Negli ultimi mesi ho iniziato a sperimentare seriamente con i modelli di intelligenza artificiale in locale, e devo dire che la svolta per me è arrivata con Ollama. Se come me lavorate quotidianamente con server, terminali e configurazioni, l’idea di avere un LLM che gira interamente sul vostro PC — senza mandare dati a nessun cloud — è semplicemente irresistibile.

Il motivo che mi ha spinto a provare Ollama è duplice: da un lato la privacy, perché come sysadmin gestisco spesso informazioni sensibili di clienti e non voglio che finiscano su server di terze parti; dall’altro la velocità, perché avere un modello AI locale significa zero latenza di rete e pieno controllo sulle risorse. In questa guida vi mostro passo passo come installare Ollama, scaricare un modello e iniziare a usarlo concretamente, esattamente come ho fatto io sulla mia workstation.

Che vogliate usare l’AI per generare script, analizzare log, scrivere documentazione o semplicemente sperimentare, questa procedura funziona su Windows, macOS e Linux. Vi racconto anche le difficoltà che ho incontrato e come le ho risolte, perché — fidatevi — non è stato tutto liscio al primo tentativo.

Cos’è Ollama e Perché Usare un Modello AI in Locale

Ollama è un tool open source che permette di scaricare, gestire e lanciare modelli di linguaggio (LLM) direttamente sulla propria macchina. Pensatelo come un Docker per i modelli AI: con un singolo comando potete tirare su modelli come Llama 3, Mistral, Gemma 2, Phi-3, Qwen 2.5 e molti altri.

I vantaggi principali che ho riscontrato nella mia esperienza sono:

- Privacy totale: i dati non escono mai dal vostro PC

- Nessun abbonamento: una volta scaricato il modello, funziona offline

- Personalizzazione: potete creare Modelfile personalizzati con system prompt specifici

- Integrazione via API: Ollama espone un’API REST locale compatibile con tantissimi tool

- Supporto GPU: sfrutta NVIDIA CUDA, AMD ROCm e Apple Metal per accelerazione hardware

Requisiti Hardware e Software Minimi

Prima di partire con l’installazione, parliamo di requisiti. Nella mia esperienza, il fattore più critico è la RAM — e se avete letto il mio articolo su perché la RAM è così costosa e come risparmiare sull’upgrade, sapete già quanto questo componente sia fondamentale.

Ecco le specifiche minime che consiglio:

- Modelli 7B parametri (Llama 3.1 8B, Mistral 7B): almeno 8 GB di RAM, meglio 16 GB

- Modelli 13B parametri: almeno 16 GB di RAM

- Modelli 70B parametri: almeno 48-64 GB di RAM (o GPU dedicata con VRAM sufficiente)

- GPU consigliata: NVIDIA con almeno 6 GB VRAM per accelerazione CUDA

- Spazio disco: dai 4 GB ai 40+ GB a seconda del modello scelto

- Sistema operativo: Windows 10/11, macOS 11+, Linux (Ubuntu, Debian, Fedora, ecc.)

Il mio setup di test: una workstation con CPU AMD Ryzen 7, 32 GB di RAM DDR5 e una NVIDIA RTX 3060 12 GB. Con questa configurazione i modelli da 7-8B girano in modo assolutamente fluido.

Installazione di Ollama su Windows, macOS e Linux

Installazione su Linux (la mia scelta preferita)

Su Linux l’installazione è semplicissima. Ollama fornisce uno script ufficiale che fa tutto in automatico:

curl -fsSL https://ollama.com/install.sh | shQuesto comando scarica il binario, lo installa in /usr/local/bin/ e configura un servizio systemd chiamato ollama. Dopo l’installazione, verificate che il servizio sia attivo:

sudo systemctl status ollamaSe tutto è andato bene, vedrete lo stato active (running). In caso contrario:

sudo systemctl start ollama

sudo systemctl enable ollamaInstallazione su Windows

Per Windows, scaricate l’installer direttamente dal sito ufficiale ollama.com/download. È un classico file .exe: doppio click, next, next, finish. Ollama si installa come applicazione di sistema e gira in background nella system tray.

Installazione su macOS

Su macOS potete usare il pacchetto .dmg dal sito ufficiale oppure, se preferite Homebrew:

brew install ollamaSu Mac con chip Apple Silicon (M1/M2/M3/M4), Ollama sfrutta automaticamente Metal per l’accelerazione GPU, e devo dire che le performance sono eccellenti.

Come Scaricare e Lanciare il Primo Modello AI con Ollama

Ecco il momento più bello: scaricare il vostro primo modello. Aprite il terminale e digitate:

ollama pull llama3.1Questo comando scarica Llama 3.1 8B di Meta, uno dei modelli open source più performanti attualmente disponibili. Il download pesa circa 4.7 GB nella versione quantizzata Q4_0.

Una volta completato il download, per avviare una conversazione interattiva basta:

ollama run llama3.1Vi troverete davanti a un prompt dove potete digitare qualsiasi domanda o istruzione. Per uscire, digitate /bye.

I Modelli che Consiglio per Iniziare

Dopo aver testato diversi modelli, ecco quelli che uso regolarmente nel mio lavoro quotidiano:

- llama3.1:8b — Il miglior rapporto qualità/risorse, ottimo per code generation e analisi

- mistral — Molto veloce, eccellente per task di scrittura e ragionamento

- codellama — Specializzato nel codice, perfetto per generare script Bash, Python, PHP

- gemma2:9b — Il modello di Google, sorprendentemente capace per le sue dimensioni

- qwen2.5-coder:7b — Il mio preferito per la generazione di codice, incredibilmente preciso

- phi3:mini — Leggerissimo, ideale se avete poca RAM

Per vedere tutti i modelli disponibili sul vostro sistema:

ollama listE per rimuovere un modello che non usate più e liberare spazio:

ollama rm nome-modelloUtilizzo Avanzato: API, Modelfile e Integrazione con Altri Tool

Usare l’API REST di Ollama

Una delle funzionalità che uso di più è l’API REST che Ollama espone di default sulla porta 11434. Questo mi permette di integrare l’AI nei miei script di automazione. Ecco un esempio con curl:

curl http://localhost:11434/api/generate -d '{

"model": "llama3.1",

"prompt": "Genera uno script bash per monitorare lo spazio disco e inviare alert via email",

"stream": false

}'La risposta è in formato JSON, facilmente parsabile con jq o qualsiasi linguaggio di programmazione.

Creare un Modelfile Personalizzato

I Modelfile sono la vera potenza nascosta di Ollama. Vi permettono di creare versioni personalizzate dei modelli con prompt di sistema specifici. Ecco un esempio che ho creato per il mio lavoro da sysadmin:

# File: Modelfile-sysadmin

FROM llama3.1

SYSTEM """

Sei un esperto system administrator Linux specializzato in Plesk,

Nginx, Apache, Postfix e sicurezza server. Rispondi sempre con

comandi specifici e testati. Quando dai istruzioni, specifica

sempre il sistema operativo e la versione del software.

Rispondi in italiano.

"""

PARAMETER temperature 0.3

PARAMETER num_ctx 4096Per creare il modello personalizzato:

ollama create sysadmin-assistant -f Modelfile-sysadminE per usarlo:

ollama run sysadmin-assistantVi assicuro che avere un assistente AI specializzato nel vostro ambito fa una differenza enorme nella qualità delle risposte. Lo uso regolarmente quando devo risolvere problemi complessi, un po’ come quelli che racconto nelle mie guide su Fail2Ban su Plesk o sulla sicurezza WordPress contro attacchi brute force.

Interfacce Grafiche per Ollama

Se il terminale non fa per voi (anche se dovreste imparare ad amarlo!), esistono diverse interfacce grafiche web che si collegano a Ollama:

- Open WebUI (ex Ollama WebUI) — L’interfaccia più completa, simile a ChatGPT, installabile via Docker

- Chatbox — App desktop multipiattaforma, molto intuitiva

- Jan — Alternativa elegante con supporto nativo a Ollama

Per installare Open WebUI con Docker (il mio consiglio):

docker run -d -p 3000:8080

--add-host=host.docker.internal:host-gateway

-v open-webui:/app/backend/data

--name open-webui

--restart always

ghcr.io/open-webui/open-webui:mainPoi aprite il browser su http://localhost:3000 e avrete un’interfaccia identica a ChatGPT ma completamente locale.

Problemi Comuni e Come Li Ho Risolti

All’inizio non è stato tutto rose e fiori. Ecco i problemi che ho incontrato e le soluzioni:

Il modello è lentissimo (solo CPU)

Se Ollama non rileva la GPU, il modello gira interamente su CPU ed è molto lento. Su Linux con NVIDIA, verificate di avere i driver corretti e il CUDA toolkit installato:

nvidia-smi # verifica che la GPU sia riconosciuta

ollama run llama3.1 # nei log vedrete se usa CUDASe la GPU non viene rilevata, reinstallate i driver NVIDIA più recenti e riavviate il servizio Ollama.

Errore “out of memory”

Questo succede quando il modello è troppo grande per la vostra RAM/VRAM. La soluzione è usare versioni quantizzate più leggere:

ollama pull llama3.1:8b-instruct-q4_0 # versione più leggeraOppure passare a un modello più piccolo come phi3:mini (3.8B parametri, circa 2.3 GB).

Ollama non risponde sulla porta 11434

Controllate che il servizio sia attivo e che non ci siano firewall che bloccano la porta:

sudo systemctl restart ollama

ss -tlnp | grep 11434Casi d’Uso Reali nel Mio Lavoro Quotidiano

Per darvi un’idea concreta di come uso Ollama nel mio lavoro da system administrator:

- Analisi log: copio un blocco di log sospetti e chiedo al modello di identificare pattern di attacco

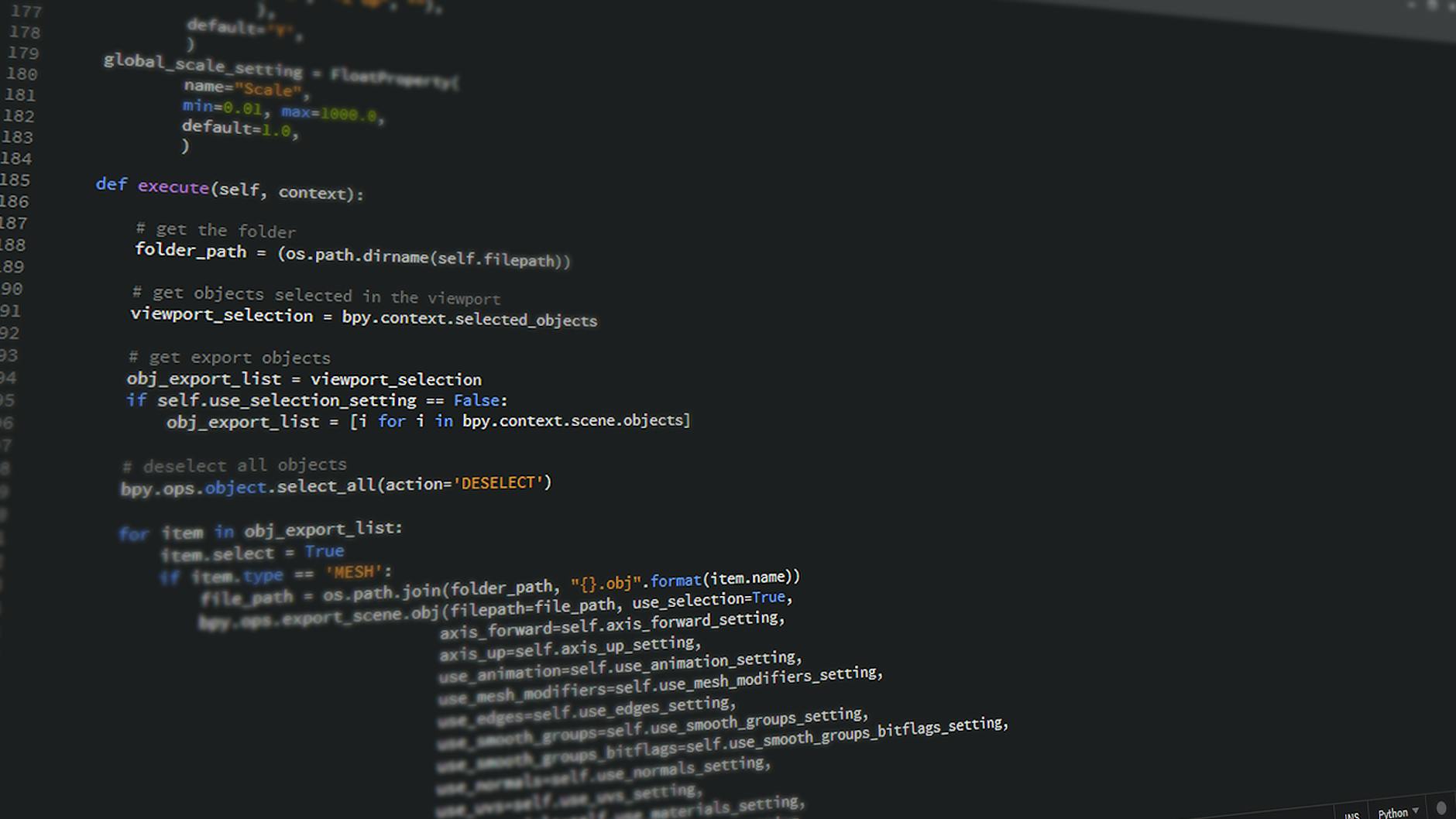

- Generazione script: creo script Bash per automazioni, backup, monitoraggio — il modello produce codice funzionante che poi verifico

- Troubleshooting: quando incontro un errore oscuro, lo sottopongo al modello con tutto il contesto

- Documentazione: genero bozze di documentazione tecnica per procedure che ho implementato

- Refactoring configurazioni: ottimizzazione di configurazioni Nginx, Apache, Postfix

Ad esempio, quando lavoravo alla procedura per configurare SPF, DKIM e DMARC su Plesk, ho usato il mio modello locale per verificare la sintassi dei record DNS generati — un aiuto prezioso per evitare errori.

Aggiornare Ollama e i Modelli

Ollama è un progetto in continua evoluzione. Per aggiornare il tool stesso su Linux:

curl -fsSL https://ollama.com/install.sh | shLo stesso script rileva la versione esistente e aggiorna automaticamente. Per aggiornare un modello a una versione più recente:

ollama pull llama3.1 # riscarica l'ultima versione disponibileVi consiglio di controllare periodicamente il catalogo modelli di Ollama per scoprire nuovi modelli appena rilasciati.

FAQ

Quanta RAM serve per usare Ollama con un modello AI in locale?

Per i modelli da 7-8 miliardi di parametri (come Llama 3.1 8B o Mistral 7B) servono almeno 8 GB di RAM, ma consiglio 16 GB per un’esperienza fluida. Per modelli più grandi da 13B servono 16-32 GB, mentre per i 70B si parla di 48-64 GB. Se avete una GPU con VRAM dedicata, il modello viene caricato lì, alleggerendo la RAM di sistema.

Ollama funziona senza GPU dedicata, solo con la CPU?

Sì, Ollama funziona perfettamente anche senza GPU, utilizzando solo la CPU. Le risposte saranno più lente rispetto all’accelerazione GPU, ma con modelli piccoli (phi3:mini, gemma2:2b) la velocità è comunque accettabile. Su Mac con Apple Silicon le performance sono ottime grazie all’architettura unified memory.

I miei dati sono al sicuro usando un modello AI in locale con Ollama?

Assolutamente sì. Questa è la ragione principale per cui ho scelto Ollama: tutto gira localmente sul vostro PC. Nessun dato viene inviato a server esterni. Potete persino scollegare Internet dopo aver scaricato il modello e continuerà a funzionare perfettamente.

Posso usare Ollama per programmare e generare codice?

Certo, ed è uno degli usi più efficaci. Modelli come codellama, qwen2.5-coder e lo stesso llama3.1 sono eccellenti nella generazione di codice. Li uso quotidianamente per script Bash, configurazioni Nginx, query SQL e codice Python. Il consiglio è di creare un Modelfile dedicato con un system prompt specifico per la programmazione.

Qual è la differenza tra Ollama e ChatGPT?

La differenza fondamentale è che ChatGPT gira sui server di OpenAI (cloud), mentre Ollama esegue i modelli direttamente sul vostro hardware. ChatGPT usa modelli proprietari generalmente più potenti (GPT-4o, o3), ma richiede abbonamento e connessione Internet. Ollama è gratuito, offline, privato, ma i modelli open source potrebbero essere meno performanti su task molto complessi.

Conclusione

Installare e usare un modello AI in locale con Ollama è stato per me un vero game changer. In pochi minuti avete un assistente intelligente che gira interamente sul vostro PC, senza abbonamenti, senza limiti di utilizzo e con la certezza che i vostri dati restano al sicuro.

La procedura è semplice: installate Ollama, scaricate un modello con ollama pull, lanciatelo con ollama run e siete operativi. Per un utilizzo professionale, vi consiglio di creare Modelfile personalizzati e di esplorare l’integrazione tramite API REST.

Se siete system administrator come me, vi garantisco che avere un LLM locale diventerà parte integrante del vostro workflow. Dalla generazione di script all’analisi di log, passando per il troubleshooting di configurazioni complesse — le possibilità sono enormi.

Avete già provato Ollama o altri strumenti per eseguire AI in locale? Quale modello preferite? Fatemelo sapere nei commenti, sono curioso di confrontare le esperienze!